中国のIT企業Alibabaとmodelscopeが共同で公開したtext-to-videoモデルが最近話題を集めています。 このモデルは、テキストを入力してAI動画制作を可能にする動画プログラムで、オープンソースとして公開されており、誰でも無料で試すことができます。

多くの開発者の方々の努力により、huggingfaceサイトですぐにAI動画を制作することができ、高スペックのPCをお持ちの方はWebUIに拡張機能としてmodelscopeをインストールして個人PCでもAI映像を生成することができます。

無料で動画を生成するAIサイト

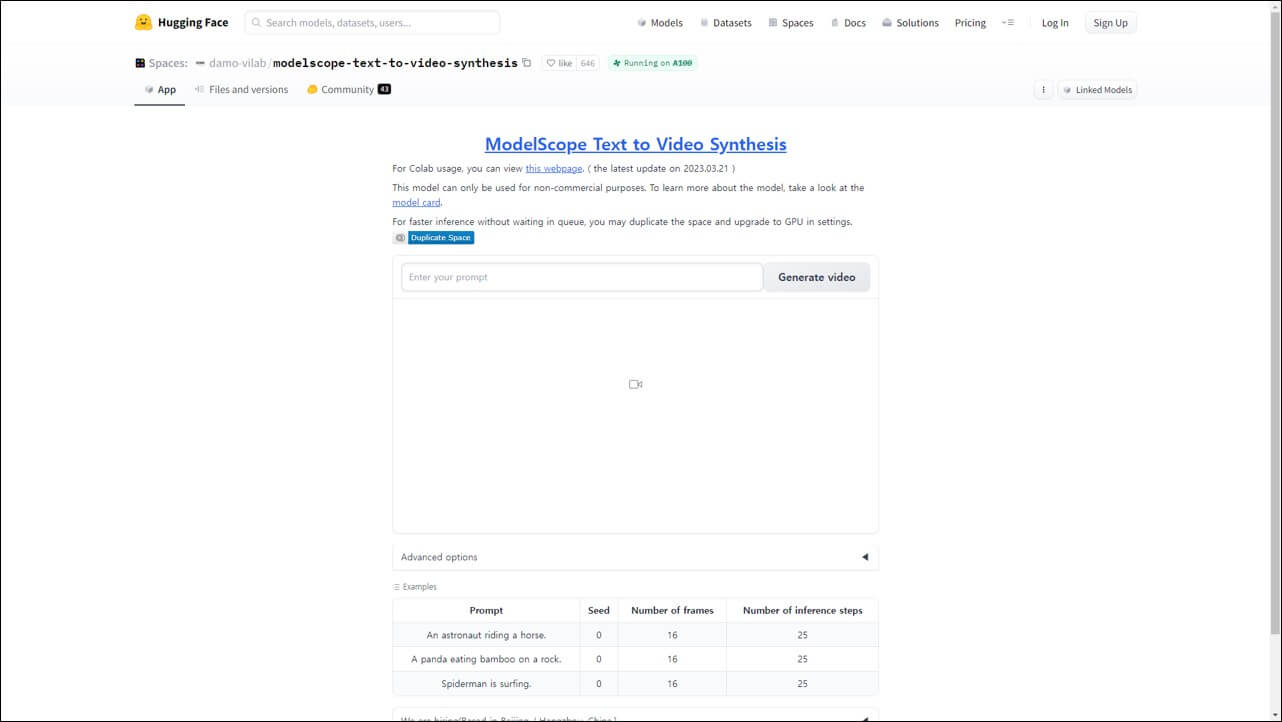

まずはhuggingfaceサイトで無料でAI動画を制作する方法を紹介します。

1. huggingface AI 動画制作ページに移動し、Enter your prompt入力欄に映像を表現するプロンプトを入力します。

プロンプトは必ず英語で入力する必要があり、以下のプロンプト例のように簡潔に一文で映像を表現するキーワードを入力することをお勧めします。 例えば、走る猫の映像を生成したい場合は、running catと入力します。

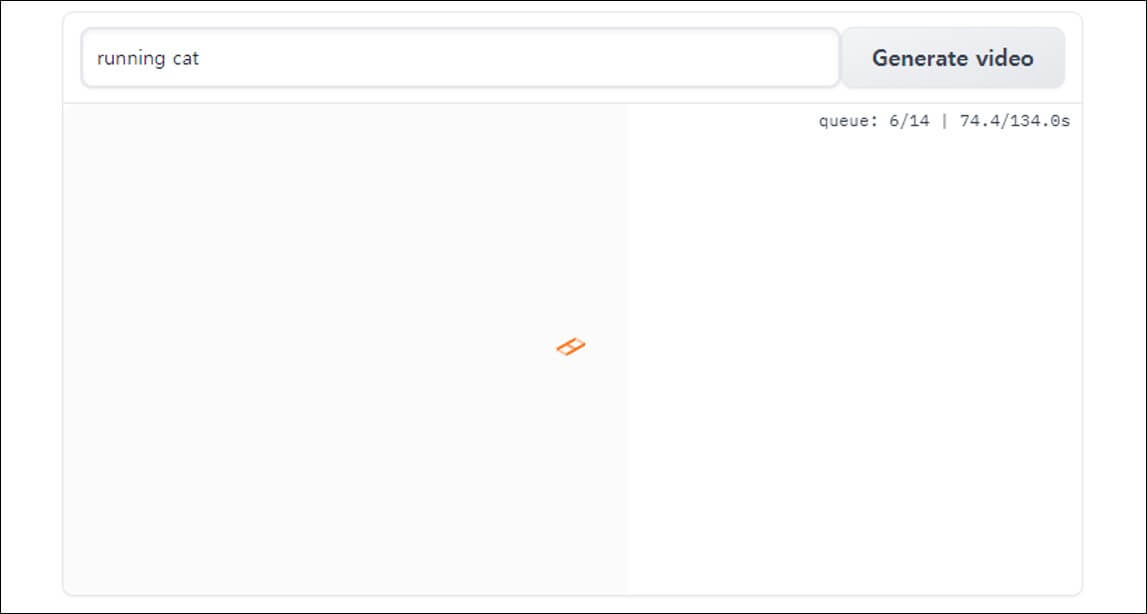

2. プロンプトを作成した後、Generate videoをクリックすると動画制作を開始します。通常3~5分程度かかります。

サーバーの状態によってERRORが発生し、動画の生成ができない場合がしばしばありますが、このような場合には、30分〜1時間程度後に再試行してください。

3. 映像が生成された後、サイトですぐに再生することができ、気に入った場合は、右クリック>動画を別名で保存をクリックしてダウンロードすることができます。

WebUIに拡張機能インストール

PCのスペックが良ければ、WebUIというプログラムにmodelscopeという拡張プラグインをインストールして個人PCでも使ってみることができます。まず、Stable Diffusion Web UIをダウンロードし、webui-user.batファイルを実行した後、下記の内容を進めてください。

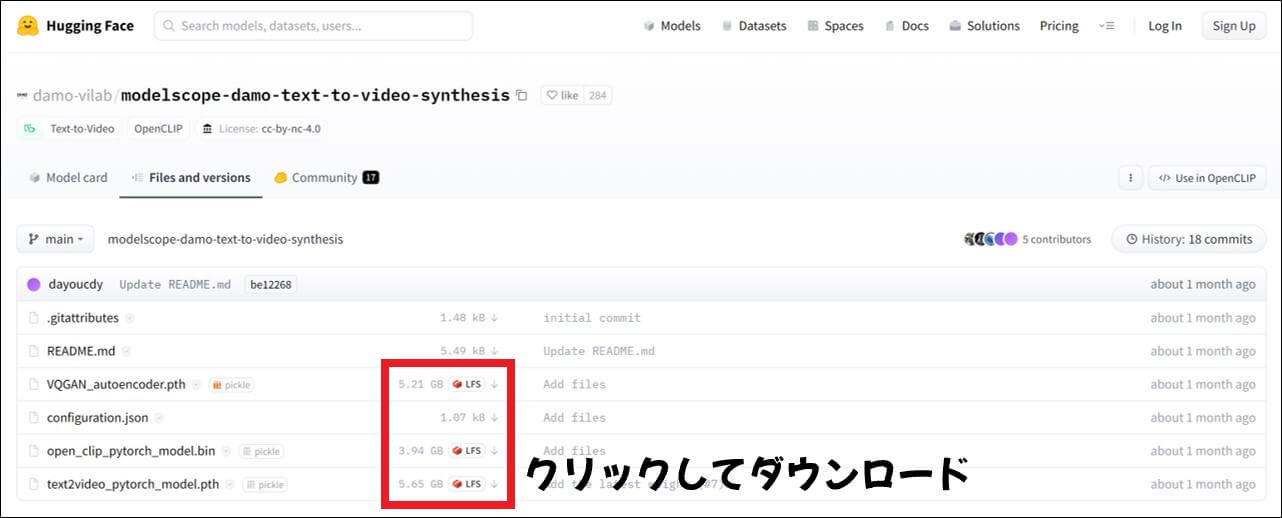

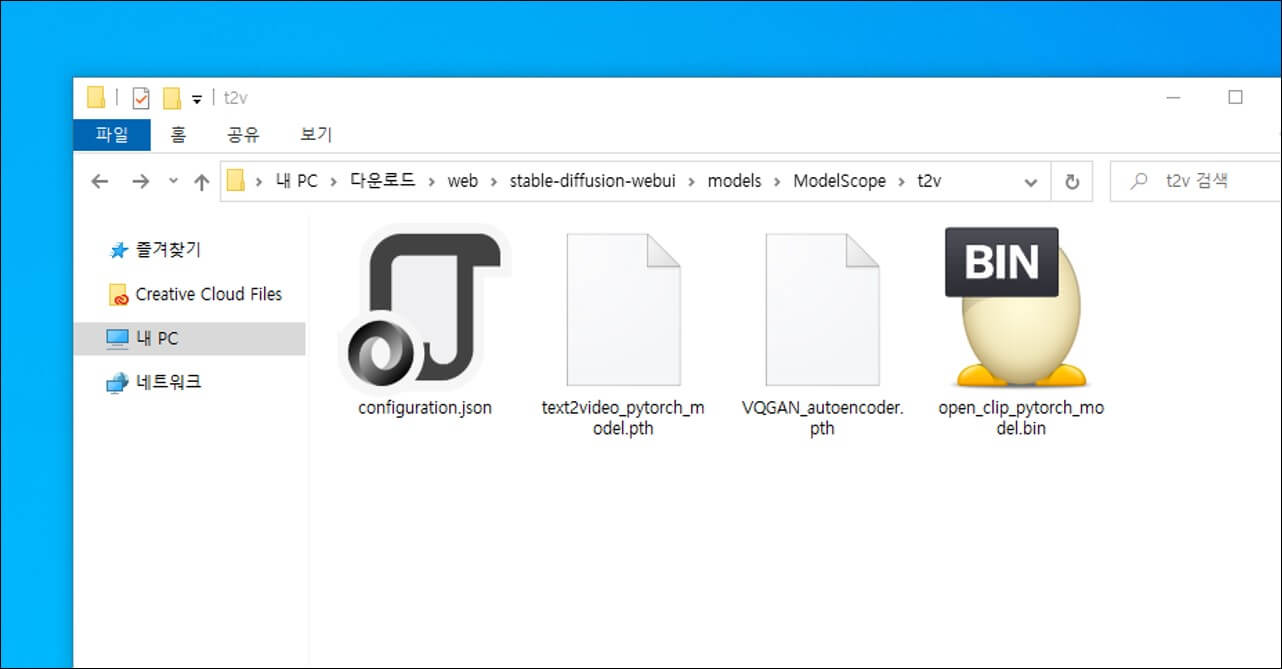

1. AIモデルのインストールページに移動した後、下記のリストに含まれるファイルをクリックしてダウンロードしてください。全て必ず必要なファイルです。

- VQGAN_autoencoder.pth

- configuration.json

- open_clip_pytorch_model.bin

- text2video_pytorch_model.pth

2. ダウンロードしたAIモデルをWebUIインストールフォルダ > models > ModelScope > t2vフォルダに貼り付けます。

modelsフォルダにModelScopeがない場合、右クリック>新規作成>フォルダの順にクリックして新しいフォルダを作成し、名前をModelScopeに変更します。

次にModelScopeフォルダを開き、そのフォルダに再びt2vフォルダを作成し、その場所にダウンロードした4つのファイルを全て貼り付けてください。

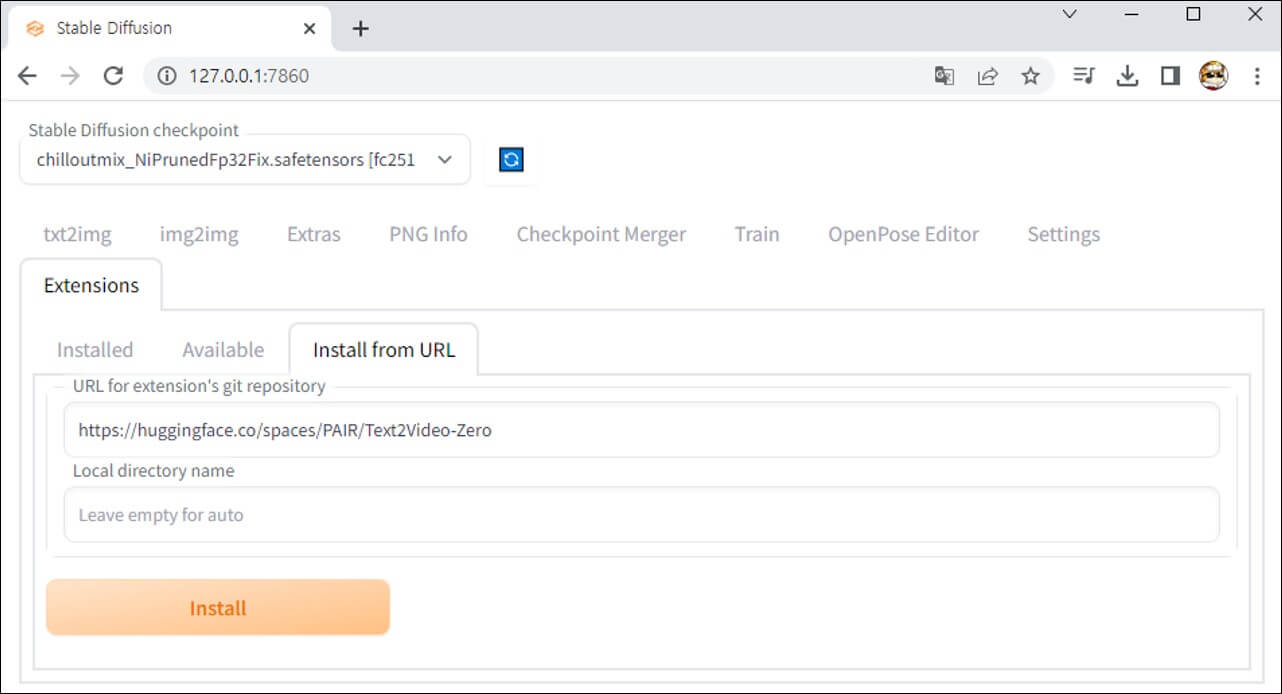

3. webui-user.batを実行した後、インターネットアドレス欄に127.0.0.0.1:7860を入力してWebUIサイトにアクセスします。

4. Extensions(拡張機能) > Install form URLをクリックして、URL forの下に https://github.com/deforum-art/sd-webui-modelscope-text2video このアドレスを貼り付けた後、Installを押してインストールを進めます。

5. インストールが完了したら、下にInstall…という文字が表示され、WebUIを終了して再実行します。

AIで動画を自動生成

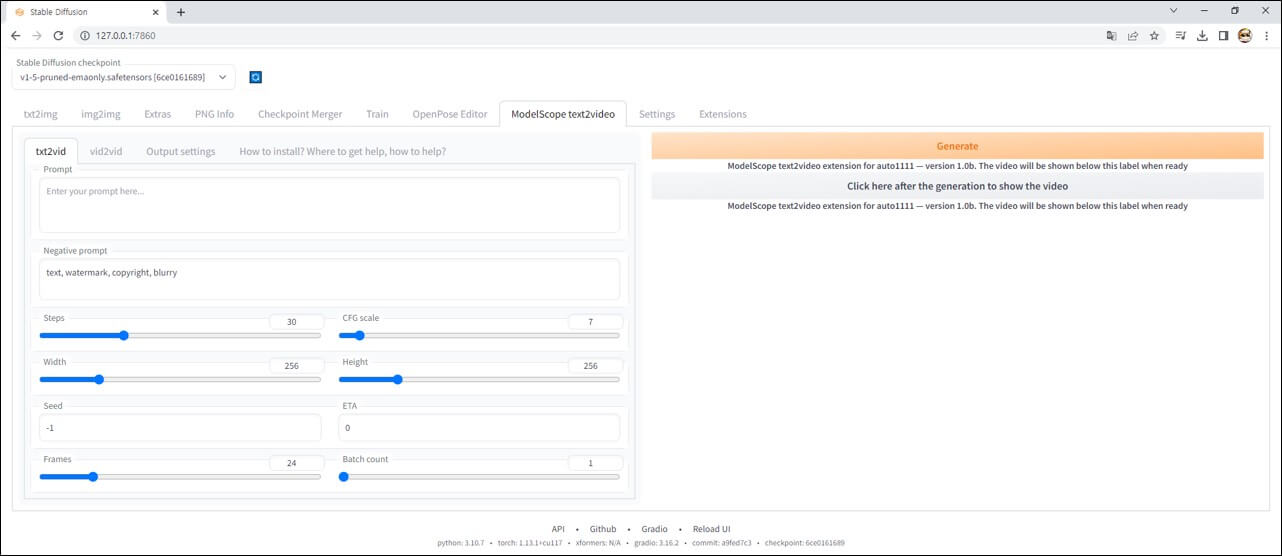

1. WebUIを再実行し、新しく追加されたModelScope text2vid タブをクリックします。

2. Stable Diffusion checkpoint 下のリストをクリックしてv1-5-pruned-emaonly.v1-5-pruned-emaonlyモデルを選択します。

3. Enter your prompt here入力欄に映像を表現するプロンプトを英語で入力し、Generateボタンを押すとAI映像を生成することができます。

Generateボタンをクリックした後、cmdを見るとconfing namespaceで数秒~数十秒くらい止まっているはずですが、プログラムを動作させるためローディング中で、この時、Generateボタンをもう一度押すとwebuiやPCが落ちることがあります。

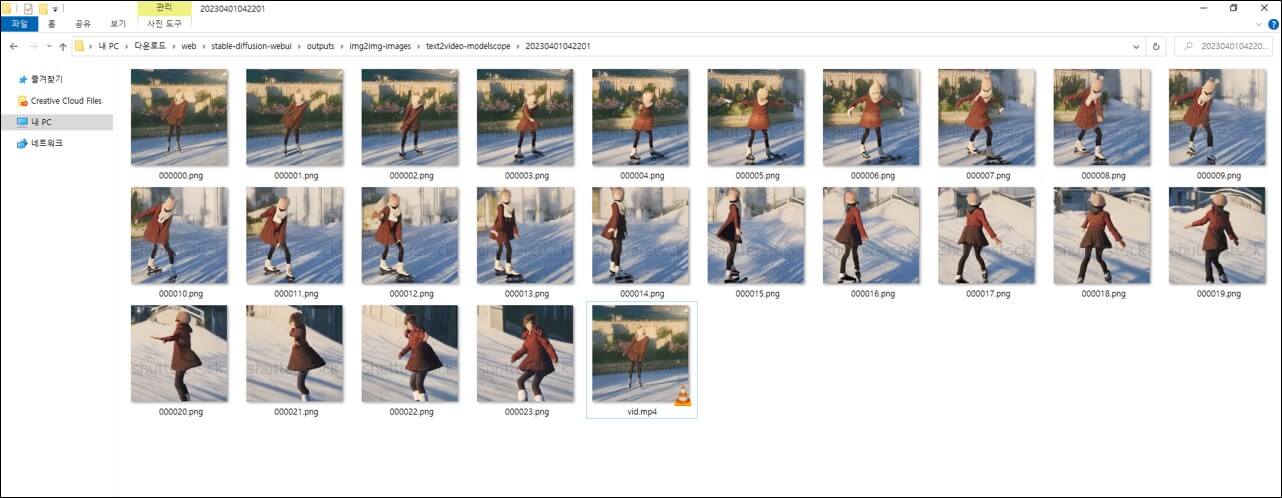

4. AIが生成した動画はWebuiインストールフォルダ > outputs > img2img-images > text2video-modelscope で確認できます。

私は「really attractive anime girl skating, by makoto shinkai, cinematic lighting」というプロンプトを使ってAI映像を制作してみました。

生成されたAI映像のクオリティが少し低いですが、スケートをしている様子をそれなりによく表現しているのが不思議ですね。 オープンソースで公開されたので、今後どのように発展していくのか本当に楽しみです。

エラーが発生した場合の解決方法

text to video方式はまだ開発初期段階のため、様々なエラーが発生し、高スペックのPCを必要とします。正常に使用するためには、最低12GBのNVIDIA GeForce RTX 2080 Tiグラフィックスカードが必要であり、それ以下では使用が難しい場合があります。 (githubで192×192解像度の動画をvram 4gbで動作させることに成功した事例があります。)

The file may be malicious, so the program is not going to read it.

You can skip this check with –disable-safe-unpickle commandline argument.

あるいはtorch.cuda.OutOfMemoryError: CUDA out of memoryエラーの場合、それぞれファイルを悪質なファイルとして誤って認識して実行しないバグとグラフィックカードのvramが不足して発生するエラーです。

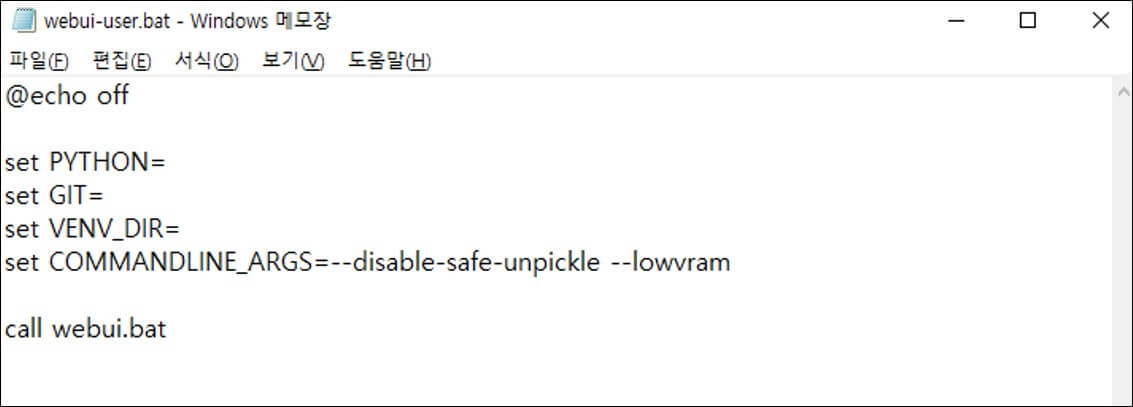

この二つのエラーはとても簡単に解決することができます。まず、webuiを終了して、webui-user.batを右クリック>編集をクリックしてメモ帳を開きます。 set COMMANDLINE_ARGS= の横に --disable-safe-unpickle --lowvramを追加した後保存し、webuiを再実行するとエラーが解決されたことが確認できます。

グラフィックカードVramが12GB以下の場合、このコマンドラインを追加してもCUDA out of memoryが発生することがありますが、このような場合は、ModelScope text2vidで映像を生成する時、画像サイズを192×192に縮小し、フレーム値も縮小して生成してみてください。